Este ensayo fue publicado el 22 de febrero de 2025 por la revista indexada Voces de la Educación Vol. 10 Núm. 19 (2025), con el titulo y en el siguiente vínculo: "El plan sectorial de educación 2025-2030 y la evaluación educativa. Algunos hechos, datos, opiniones y sugerencias | Voces de la educación"

El sentido común no es resultado de la educaciónVíctor Hugo

“El Plan sectorial de Educación 2025-2030 y la Evaluación Educativa. Algunos hechos, datos, opiniones y sugerencias.”

Autor. Juan Carlos Palafox Pérez de Salazar .

A manera de Marco Teórico.

Sin pretender de ninguna manera desarrollar un texto teórico-académico sobre planificación, programación y/o evaluación de la educación, se hace conveniente en el tema del diseño e instrumentación de las políticas públicas, partir de un referente más amplio que nos permita ubicar a la gestión pública dentro de la administración como disciplina que debe y está presente en toda actividad humana, por lo que en ese sentido y solo a nivel enunciativo para ubicar el tema objeto de este ensayo argumentativo, “El Plan Sectorial de Educación 2025-2030” de México, citaremos solo algunas escuelas, que nos permita identificar la multiplicidad de enfoques que en esta materia se han dado a lo largo de los últimos años.

Según la literatura, podemos citar entre otras las siguientes escuelas:

• Escuela Clásica de la Administración. Frederick Taylor, Henry Fayol y Max Weber.

• Escuela Empírica. Ernest Dale.

• Escuela de Relaciones Humanas. Elton Mayo, Douglas McGregor y Abraham Maslow.

• Escuela Matemática. Herbert A. Simon y James Gary March.

• Escuela de la contingencia. Joan Woodward y Paul Lawrence.

• Escuela de la Calidad Total. William Deming y Joseph Juran.

• Escuela Sistémica de Pensamiento. Peter Senge y Stafford Beer.

• Escuela de la Excelencia Empresarial. Tom Peters y Robert Waterman.

• Escuela del Aprendizaje Organizacional. Chris Argyris y Donald Schön.

• Escuela de la Innovación. Clayton Christensen y Henry Chesbrough.

• Escuela de la Responsabilidad Social Empresarial. Archie Carroll y John Elkington.

• Escuela de la Estrategia. Michael Porter y Gary Hamel.

• Escuela de la Planeación Prospectiva. Gastón Berger, Tomás Miklos.

• Escuela referida a la Teoría de Sistemas. Ludwig von Bertalanffy y Mary Parker Follet.

Conviene mencionar que estas escuelas son delimitaciones académicas puntuales, no necesariamente son mutuamente excluyentes, ni independientes, sino que se entremezclan y comparten elementos, metodologías, herramientas y enfoques, pero su delimitación permite identificar sus énfasis y perspectivas.

Así mismo, todas estas escuelas como se mencionó antes, se enmarcan en un ámbito más amplio y no específicamente referido a la administración pública, sino más bien al ámbito general y de las empresas, pero que, de alguna manera afecta, influye o determina la acción gubernamental, ámbito que incorpora otros conceptos muy suyos que hay que sumar a la ecuación, “Gobierno, Gobernanza y Gobernabilidad”; referidos de manera sintética a :

Por último, para cerrar esta breve introducción del tema de la gestión, la administración y la planificación, conviene tomar en cuenta lo que la CEPAL a nivel regional menciona como introducción en su página WEB, “la planificación gubernamental es un ejercicio técnico político, que permite trazar rutas de transformación de la realidad que se pretende cambiar. Planificar es apostar al presente y al futuro de las sociedades.”

En este contexto, el presente ensayo argumentativo de ninguna manera pretende hacer un sesudo análisis del marco teórico en el que se ubica el que próximamente será publicado como “Programa Sectorial de Educación 2025-2030”, como tampoco pretende hacer un recuento de contenidos, similitudes y contradicciones que este instrumento de planificación gubernamental ha tenido a lo largo de su historia, sino que pretende compartir con quienes les interese este tema, algunos datos, hechos y circunstancias que el autor ha visto, vivido y experimentado a lo largo de poco más de 50 años en que se ha vinculado con la educación mexicana e internacional en distintas instancias de la gestión gubernamental y multilateral, para que a partir de ello, el lector complemente su propia experiencia y visión de las cosas en relación a los procesos formales e informales de la planificación educativa, con vistas al programa sectorial de educación 2025-2030 próximo a ser presentado por la nueva administración del país y en específico en lo relacionado a la evaluación educativa, complementando el ensayo con algunos datos que dan cuenta de los actuales niveles de aprendizaje de México en el contexto internacional.

Entretelones histórico-políticos.

Quizá́ una de las acciones de gobierno a la que estamos acostumbrados en el México contemporáneo, sea la publicación del Plan Nacional de Desarrollo al inicio de cada sexenio o administración , en el cual se establece la rectoría del estado en materia de desarrollo nacional y que obliga a los diferentes niveles de gobierno a presentar los programas especiales, regionales e institucionales, que determinarán las prioridades nacionales y orientarán las políticas públicas de diversos sectores como salud, comunicaciones, energía, etcétera, entre los que destaca para el futuro próximo el Programa Sectorial de Educación 2025- 2030. Lo anterior, no siempre fue así́, aun cuando desde el sexenio de Lázaro Cárdenas se presenta un plan sexenal, su existencia formal data de poco más de 40 años. Anteriormente, no existía la obligación constitucional y sistemática de formular un programa que sirviera de “norte” para la gestión del gobierno y de los distintos sectores a lo largo de toda una administración.

Ahora bien, en materia educativa quizáś la primera referencia de un esfuerzo de esta naturaleza —parcial, ya que solo se refería a la alfabetización y la educación primaria— fue el plan de los once años, ideado por uno de los únicos dos secretarios de Educación Pública que ocupó el cargo en dos ocasiones y que además ostentó el puesto de Director General de la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO), Jaime Torres Bodet . Plan que se planteó́ como una verdadera política de Estado, abarcando dos periodos de gobierno, desde 1958 hasta 1970, pero que, a pesar de haber sido un gran avance, en definitiva, no logró los objetivos propuestos.

Un segundo esfuerzo no sistemático normativamente como obligatorio, fue el documento que en su momento se denominó: “Programas y Metas del Sector Educativo 1978-1982” (Daphne Ángeles. 2016), inicialmente esbozado por el fugaz secretario de educación pública (1976-1977) Porfirio Muñoz Ledo ; propuesta que fue retomada, reformulada y priorizada por el otro Secretario de Educación Pública que también ocupó en dos ocasiones el mismo cargo, Fernando Solana Morales , instrumento que además de haber incluido todo el espectro educativo nacional en 52 programas, focalizó la acción de su gestión en 12 de ellos como prioritarios, dentro de los cuales el número uno fue el “Programa Primaria Para Todos los Niños”, también conocido como el 3PTN, que permitió́ generar condiciones para que por primera vez en México se alcanzara la universalización de la atención de ese nivel educativo, objetivo que como ya se planteó, fue postulado original de la Constitución del 17 y meta del “Plan de los Once Años”.

Cabe mencionar que esa priorización no es gratuita y surge de la reflexión que Solana Morales hace sobre el hecho de que después de 60 años de promulgada la constitución de 1917, aún no se cumplía con el anhelo del Artículo Tercero, “la educación elemental debe ser laica, obligatoria y gratuita”, postulado fruto de la revolución Mexicana, donde el país pierde según algunos historiadores, más de un millón de personas como resultado de ese cruento movimiento revolucionario, en que se pasó de poco más de 15 millones de habitantes en 1910 (INEGI 2010), a tan solo cerca de 11 en 1921 (INEGI 2010), población que además, en un 75% ostentaba la lamentable condición de analfabetismo (Solana, et al 2011).

Así entonces y como siguiente etapa de los esfuerzos anteriores, es que a nivel país nace formalmente el Plan Nacional de Desarrollo 1983-1988 , y derivado de él, los programas sectoriales, como una obligación constitucional del gobierno mexicano al inicio de cada administración, para determinar las acciones que el gobierno federal se propone realizar.

Por tanto, desde entonces y hasta la fecha, todas las administraciones del Partido Revolucionario Institucional PRI, como del Partido Acción Nacional PAN y del Movimiento de Regeneración Nacional MORENA, estuvieron y están obligadas por ley a presentar estos programas y, de alguna u otra forma, a ceñirse a su cumplimiento más o menos riguroso.

Algunas distorsiones del modelo

Ahora bien, lamentablemente a pesar de la existencia de estos mecanismos de planeación de la política nacional y en específico del sector educativo, no necesariamente el espíritu con que se crearon estas instancias de planificación, gestión, seguimiento, control, rendición de cuentas y hasta de apoyo a la contraloría social, han cumplido con su cometido, sino que en algunos casos, que si no en gran parte, son solo tema al principio de las distintas administraciones desde que se instauro la obligación de elaborarlos, pasando al olvido casi de manera inmediata o quedando solo para el uso de instancias gubernamentales de control burocrático, pero nunca para el seguimiento público de lo que ahí se plantea punto a punto, de forma que la sociedad en general sea informada con rigurosidad de su avance o retroceso, así como de las medidas correctivas a que haya lugar.

De hecho, en el sector educativo no tan solo el Programa Sectorial queda en el “limbo” de cierta invisibilidad, sino que en algunas ocasiones ha sido sustituido parcial o totalmente por otro tipo de instrumento, más político que técnico. Un caso emblemático se da en la administración de 1988 a 1994, cuando a la mitad del sexenio se da un cambio en el liderazgo de la SEP, y en mayo de 1992 el gobierno federal, los gobiernos de los estados y el Sindicato Nacional de los Trabajadores de la Educación suscribieron el Acuerdo Nacional para la Modernización de la Educación Básica, en el que se establecieron tres líneas centrales de acción: la reorganización del sistema educativo, la reformulación de los contenidos y materiales educativos, y la revaloración de la función social del magisterio, línea esta última, que se traduce por primera vez entre otras cosas en una estrategia referida a la administración de los recursos humanos, que enfatiza la política del sector en lo que se denominó como “Carrera Magisterial”, un modelo de escalafón horizontal cuya instrumentación absorbe la mayor atención del sector y el Programa Sectorial de Educación 1989-1994 quedó relegado a un segundo plano. Adicionalmente, durante este mismo periodo en materia de evaluación de la calidad de la educación, se da independientemente del Programa Sectorial de Educación, una iniciativa que posteriormente es reconocida por el Instituto Nacional para la Evaluación de la Educación INEE como la que dio pie a “la realización y publicación, a nivel internacional, de los primeros análisis multivariados de base censal orientados a conocer el impacto de los factores de contexto sobre la calidad de la educación en México” (INEE 2006) y que fue publicada tanto por el Banco Mundial (1992), como por la Universidad de Chicago (1994).

Otros casos de distorsión en la gestión gubernamental del sector educativo y el programa sectorial, se dan en primer término en la administración de 2000 a 2006 con el “Compromiso Social por la Calidad de la Educación” (15 de mayo de 2002) promovido por el Sindicato Nacional de Trabajadores de la Educación (SNTE) y la Secretaria de Educación Pública (SEP), que entre otras cosas coincide con el nacimiento en 2002 del Instituto Nacional para la Evaluación de la Educación INEE, institución que a pesar de haberse extinguido en 2019 afirma hasta la fecha en su página WEB, ser la “única instancia en México con la misión de realizar diagnósticos objetivos y explicativos que orientan, describen y muestran el estado de la educación y sus niveles de calidad. Contribuimos a la evaluación del Sistema Educativo Nacional con el fin de garantizar el derecho a una educación de equidad y calidad para todas las personas.”, lo cual puede ser cuestionable desde la perspectiva de las funciones que formal y paralelamente se asignaban en la SEP a la Dirección General de Evaluación Educativa desde los años 80’s.

Es de relevar que durante el periodo 1994 a 2006 en el plano internacional, México se incorpora a tres instancias relacionadas con la evaluación educativa, el Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación LLECE en 1994, el Programa para la Evaluación Internacional de Alumnos PISA en 2000 y el Proyecto Regional de Indicadores Educativos PRIE (UNESCO 2000).

Posteriormente en la administración de 2006-2012, sucede un hecho sui géneris en el nivel de educación básica, con la aparición de la llamada “Alianza por la Calidad de la Educación (ACE)” , que reemplaza casi en su totalidad al Programa Sectorial de Educación en dicho nivel y es signada por la presidencia del SNTE y la mismísima máxima magistratura de la nación, la presidencia de la República. Alianza que se gesta desde la cúpula de la representación sindical y que según algunos politólogos, da pie a la transferencia de la rectoría de estado en la materia hacia la cúpula sindical con el beneplácito del presidente del país, generando distorsiones, duplicidades y traslapes importantes en la gestión del sector, como también, disminuye de forma importante la autoridad de los Secretarios de Educación Pública de esa administración y de la siguiente , a grado tal que durante un periodo importante la titularidad de la Subsecretaría de Educación Básica es entregada a un funcionario vinculado familiarmente con la Presidente del SNTE.

En materia de evaluación educativa, en ese contexto nace lo que se conoció como “la prueba ENLACE, que diseña y aplica la SEP año con año desde 2006, de manera censal a todos los alumnos de los grados de tercero de primaria a tercero de secundaria, en las áreas de lectura, matemáticas y una asignatura adicional que cambia cada año; y la prueba Excale, que diseña y aplica el INEE desde 2005 a una muestra representativa de alumnos por modalidad educativa de escuelas y por entidad federativa, se realiza en ciclos de cuatro años en los grados de tercero de educación preescolar, tercero y sexto grados de educación primaria y en el tercer grado de educación secundaria para evaluar las áreas de matemáticas y lectura, ciencias naturales y ciencias sociales. Además, la SEP aplica una prueba ENLACE de carácter censal y anual a los estudiantes del último grado de Educación Media Superior”(INEE 2013), esfuerzo que lamentablemente dada su masividad y su vinculación a estímulos para las escuelas sin contextualizar los resultados, cae en algunas prácticas poco trasparentes y según algunas publicaciones, corruptas por lo que desaparece en 2013-2014 y es substituida por el Plan Nacional para la Evaluación de los Aprendizajes (PLANEA).

Conviene mencionar que, en materia de evaluación de los rendimientos educativos, existen otros esfuerzos realizados a lo largo de los últimos años, pero en este texto solo nos referiremos a los más emblemáticos que además tuvieron repercusiones políticas.

En adición a lo anterior, se da un caso representativo en la posterior administración -de 2012 a 2018-, cuando en un “golpe de timón” presidencial , toma un lugar preponderante por encima de cualquier otro instrumento de planeación gubernamental, el llamado “Pacto por México”, a cuyo marco se alinea no tan solo el Plan Nacional de Desarrollo, sino también los Programas Sectoriales, que en el caso de educación genera hasta una Reforma Constitucional, que además de otros temas toca sustantiva, simultánea y nuevamente la función de administración de recursos humanos de la SEP y de la evaluación educativa. En el primer caso, generando lo que se denominó el Servicio Profesional Docente (SPD), en tanto que, en el segundo aspecto, se crea el Sistema Nacional de Evaluación Educativa cuya coordinación se encarga al Instituto Nacional para la Evaluación Educativa (DOF 2015), entidad creada desde 2003, pero que, con esa misma Reforma Constitucional, además se le confiere la calidad de organismo constitucionalmente autónomo.

El INEE y el SPD.

Así entonces, como consecuencia de dicho Pacto, se da la reforma del artículo 3° Constitucional, fracciones III y IX, y sus respectivas leyes secundarias (Ley General del Servicio Profesional Docente y Ley del Instituto Nacional para la Evaluación de la Educación), así́ como modificaciones a la Ley General de Educación, que en su conjunto forman el centro del cuerpo jurídico normativo que determina el énfasis de la política educativa de la administración de aquellos años. Lo cual no fue acompañado inicialmente con una propuesta de modelo educativo, que pudiera ser el “norte” pedagógico que orientara el esfuerzo educativo nacional, sino que absurdamente dicho modelo pedagógico llega hasta el último año de aquella administración.

En ese marco normativo se vincula la evaluación educativa con las funciones que coordina el Servicio Profesional Docente -reclutamiento, selección, contratación, evaluación, promoción, capacitación y permanencia docente-. Dicho de otra forma, la función del SPD de definir la idoneidad de los docentes que postulan a ocupar una plaza de nuevo ingreso o una promoción laboral, como también para decidir en última instancia si los docentes en servicio que son evaluados deben ser capacitados, reubicados o separados de sus cargos en virtud de reiterados bajos desempeños en su evaluación, se vincula perversa y equivocadamente a las funciones del INEE, generando en el imaginario colectivo de ciertos sectores del gremio docente la idea de que el INEE era “el malo de la película”, cuando en realidad el Instituto solo era un garante técnico de que los instrumentos o pruebas de conocimientos que se aplicaba a los alumnos y/o docentes en este proceso escalafonario, cumplían con los estándares técnicos comunes a este tipo de instrumentos y marginalmente acompañar el proceso en cuanto a la secuencia administrativa definida por el SPD.

Lamentablemente, al igual que lo sucedido en otras latitudes donde se han instrumentado estrategias similares, el SPD generó una importante movilización opositora de parte de ciertos sectores de docentes, a grado tal que en el primer año de instrumentación del modelo, la autoridad educativa tiene que recurrir a la fuerza pública o hasta reubicar los procesos de evaluación a entidades federativas distintas a la de los evaluados.

Paralelamente el INEE Autónomo Constitucionalmente, que logró muchas cosas, cientos, muchas de ellas buenas, excelentes las más, que permitieron en su momento consolidar en México una instancia de alto nivel técnico, excelencia en investigación y amplios estudios estandarizados de alto nivel, en definitiva, por esa perversa vinculación sobredimensionada con el SPD y otras situaciones, acaba por tener una vida efímera que duró poco más de 16 años, lo cual quizá también se deba precisamente a que quienes formamos parte de él en sus últimos años, volamos demasiado alto sin haber entendido a cabalidad la responsabilidad e importancia en que se incurría al adquirir la calidad de ORGANISMO PÚBLICO AUTÓNOMO, sino que se siguió siendo comparsa de la autoridad federal que nos concedió dicha calidad, sin hacer honor a la misma y sin asumir el papel que se esperaba del INEE Autónomo (Palafox. 2018), en tanto que:

Nunca, haciendo gala de un juicio técnico riguroso y autónomo, se opuso al protagonismo que por mimetismo con el SPD se le imputó, SPD qué si bien en principio parecía una medida lógica, justa y racional, fue, es y será en los hechos, una política de carácter administrativo, relacionada fundamentalmente con la planeación, organización y control de los recursos humanos o capital humano de la SEP y con el escalafón de su personal docente, que según lo dicho por el propio exsecretario de Educación Pública de aquellos últimos momentos , a diciembre de 2017 solo el 35% de la vacancia cumplía con las normas y procedimientos normativos , hecho también denunciado por el Instituto Mexicano para la Competitividad A.C. (Clark, 2019), pero que en los hechos la mala imagen que esta estrategia generó en la memoria colectiva de los docentes, le fue atribuida al INEE.

Nunca, paralelamente con lo anterior, se denunció pública y oficialmente los efectos perversos del SPD en detrimento de la calidad y equidad educativa, modelo que no fue acompañado de estímulos económicos y educativos que hicieran más atractivas las plazas donde están las poblaciones más carenciadas y necesitadas del país; lo cuál en la práctica, tuvo como consecuencia que los docentes más idóneos se destinaran o seleccionaran las mejores escuelas y los que obtenían los menores puntajes se les ofrecieran las plazas en las zonas más marginadas.

Nunca, se logró ni siquiera como el borrico de la fábula, “tocar la flauta” que le permitiera al INEE desligarse de su karma, el SPD; nunca por más recursos que se invirtieron y cambios realizados, se entendió que las campañas de difusión para desvincularse de las responsabilidades que correspondían al SPD, no debían ser en los escaparates comerciales donde sacian sus curiosidades las clases distantes de la población objetivo del INEE, sino que debieron ser dirigidas a donde abrevan la información los docentes.

Nunca tampoco, se denunció que el problema de la corrupción, venta de plazas y demás vicios de la gestión del sector educativo denunciada públicamente en distintos medios , no fue -ni es- responsabilidad de los docentes, por lo que nunca se debió de haber participado en medidas que pusieron en entredicho social su labor y desempeño profesional; debiendo sí, como organismo constitucionalmente autónomo, denunciar a quienes incurrieron en responsabilidad legal y hasta penal por esos hechos, ciertas autoridades de turno, qué a cambio de pírricas ganancias electorales u otros intereses ilegítimos, renunciaron a la obligación que la Ley Orgánica de la Administración Pública Federal les establece de ser los rectores del sistema educativo mexicano (Artículo 39).

Nunca, se asumió que “la evaluación educativa no es un fin en sí mismo, ni representa la fundación del sistema educativo mexicano, éste, deviene de muchas décadas atrás y está compuesto por diversas acumulaciones históricas, producto de varias generaciones de mexicanos y mexicanas”. (Palafox, 2013).

Nunca, por falta de humildad, buen juicio y quizá también por temor a contrariar a la autoridad, se denunció lo sobredimensionado de la fracción IX del Artículo Tercero, que indicaba: “Para garantizar la prestación de servicios educativos de calidad, se crea el Sistema Nacional de Evaluación Educativa. La coordinación de dicho sistema estará a cargo del Instituto Nacional para la Evaluación de la Educación…” (DOF. 2013). Lo cual debió acotarse “a su verdadera dimensión, ya que no existe evidencia alguna en el planeta que indique que la creación de un sistema o institución de evaluación educativa garantice la prestación de servicios educativos de calidad. A un sistema de evaluación corresponde medir, calcular, diagnosticar, evaluar, determinar, recomendar o hasta juzgar y/o denunciar el estado de situación o el futuro previsible de los servicios educativos, pero en ningún caso garantizar su calidad, esto es responsabilidad de la Secretaría de Educación Pública (SEP) y de sus homólogas estatales.” (Palafox, 2013)

Finalmente, y como resultados de las movilizaciones opositoras de aquellos años , el nuevo Programa Sectorial de Educación 2019-2024, según algunos indicios, se ve empantanado en otra liga, donde a manera de “moneda de cambio”, aparentemente pacta la desaparición del INEE y del procedimiento de última instancia del SPD que separa del cargo docente a quienes no superen las evaluaciones que se les hacían, todo a cambio de detener las movilizaciones y mantener al sector en calma; cuestión que a poco rato de iniciada la gestión de Andrés Manuel López Obrados sucede, se mantiene y prolonga a todo lo largo de su administración y trae aparejada una nueva reforma constitucional para 2019.

Mejoredu

En ese “caldo de cultivo político”, donde la intencionalidad de los hechos no tiene necesariamente que ver con la educación, sino más bien con la gobernabilidad y los compromisos políticos de campaña, es que el INEE resulta ser en aquellos años, el único Órgano Autónomo Constitucional que desaparece, lo cual además en concordancia con la tercera Ley de Newton “A toda acción le corresponde una reacción igual pero en sentido contrario”, provoca un premio de consolación para la oposición, una nueva entidad denominada Comisión Nacional para la Mejora Continua de la Educación (Mejoredu), que si se me permite hacer una metáfora al respecto, me atrevería titularla como el “síndrome del niño no deseado”.

Comisión que tiene como marco básicamente una nueva Fracción IX del Artículo Tercero constitucional, que indica: “Para contribuir al cumplimiento de los objetivos de este artículo -Tercero-, se crea el Sistema Nacional de Mejora Continua de la Educación, que será coordinado por un organismo público descentralizado, con autonomía técnica, operativa, presupuestaria, de decisión y de gestión, con personalidad jurídica y patrimonio propios, no sectorizado” (DOF, 2019) Mejoredu. Fracción que remplaza la absurda aspiración de su versión para el INEE, donde como ya se comentó, la pretensión era “garantizar”, cambiándola por un razonable “contribuir”.

Comisión a quien, dentro de otras funciones, se le atribuyen en materia de evaluación, las siguientes:

a) Realizar estudios, investigaciones especializadas y evaluaciones diagnósticas, formativas e integrales del Sistema Educativo Nacional;

b) Determinar indicadores de resultados de la mejora continua de la educación;

c) Establecer los criterios que deben cumplir las instancias evaluadoras para los procesos valorativos, cualitativos, continuos y formativos de la mejora continua de la educación;…

Determinaciones que hacen migrar del enfoque del desaparecido INEE generalmente centrado en las evaluaciones del sistema, cuantitativas, estandarizadas, masivas y cuyo principal usuario fue el propio INEE, los centros de investigación, los tomadores de decisiones y posteriormente los supervisores educativos, los directores de escuelas, sus docentes y los alumnos mismos; hacia una evaluación promovida por Mejoredu más centrada en brindar herramientas y elementos que apoyen in situ a los docentes y directivos escolares, con la idea de que las evaluaciones sean desde, en y para los centros escolares, donde Mejoredu se concrete a brindarles a ellos criterios, lineamientos y herramientas que les ayude a realizar evaluaciones útiles y significativas para sus propios centros educativos, como realizarlas y como interpretarlas.

Lastimosamente y volviendo al “síndrome del niño no deseado", en principio la intención de la nueva administración fue simple y llanamente desaparecer el INEE y punto, pero en el proceso de ello y ante presiones que más que educativas, fueron políticas, se cede parcialmente y nace un Mejoredu semiautónomo, con una junta directiva negociada, tres quintas partes oficialista y dos partes de oposición, que además careció del nivel técnico-académico a la que en su momento tuvo su precedente, lo cual dificultó su operación, tomar acuerdos y responder a las necesidades educativas del país, Comisión que además queda entreverada con la SEP en las leyes secundarias, y en la práctica sin su apoyo, con un exiguo presupuesto y recursos humanos de un tercio de lo que tenía el INEE.

Adicionalmente a lo anterior, dicho nacimiento sucede en el peor momento, poco antes de iniciar la epidemia del COVID-19, situación que trastoca todas las dinámicas sociales, políticas, económicas, y por ende, educativas, no tan solo de México, sino de la mayor parte del mundo, que según el Banco Mundial trajo como consecuencia el cierre prácticamente universal de las escuelas de todos los niveles y una recesión económica generada por las medidas de control de la pandemia (Banco Mundial, 2021), que en el caso mexicano entre otras cosa se traduce en un 9.6% de abandono escolar entre el ciclo escolar 2019-20 y el de 2020-21, abandono que hasta la fecha aún no se recupera en su totalidad.

Por otra parte, el parto de Mejoredu es con "fórceps" o límites Constitucionales y de su Ley Secundaria que le impiden orientar o reorientar sus fortalezas autónomamente de lo importante a lo urgente impuesto por la coyuntura; por ejemplo, asumir un papel protagónico ante el masivo abandono antes citado de millones de niños, adolescentes y jóvenes del sistema educativo, en vez de seguir orientando una buena parte de su quehacer a proponer criterios, lineamientos y estrategias distantes de las urgencias que exige la contingencia.

Igual es prudente mencionar que en materia de evaluación e indicadores educativos, se debe reconocer que ya antes de que existieran ambas instituciones, se registran un sin número de acciones y experiencias evaluativas dentro de las que destacan a nivel internacional nuestra participación en PISA y en el LLECE , así como a nivel nacional muchas otras más (INEE, 2006); como también hay que recordar que en el pasado distante y actualmente el sistema en el cual se basa gran parte de los indicadores educativos de nuestro país, deriva indefectiblemente de un instrumento de información que opera desde principios de los años 70’s del Siglo pasado, medio Siglo atrás, la estadística educativa mejor identificada como “la 911” .

En suma, insinuar que el INEE o Mejoredu fueron o son el sumun de la verdad y la luz en educación, sobredimensiona los hechos y omite a múltiples entidades que también hacen de su quehacer académico a la educación de nuestro país, como la misma SEP, el Colegio de México, el CIDE, el CINVESTAV, ISSUE-UNAM, la UNESCO, la OEI, etc., que en sus áreas especializadas hacen gala de profundo conocimiento crítico de la educación mexicana; como también conlleva una sutil afirmación despectiva hacia José Vasconcelos, Torres Bodet, Fernando Solana, Ramón G. Bonfil, Pablo Latapí, Carlos Muñoz Izquierdo y muchos otros académicos, investigadores y educadores, insinuando que fueron ciegos o actuaron a oscuras, que solo con la aparición de estas entidades la educación mexicana por vez primera ha tenido un faro de luz, destino y norte.

Igualmente implicaría desconocer la acción faraónica de cientos, que sino miles, de especialistas, funcionarios, alumnos, padres de familia y sobre todo, millones de docentes, que a lo largo del último Siglo instrumentaron verdaderas políticas de estado en materia educativa, como las misiones culturales, la creación de un verdadero órgano autónomo en materia educativa -la UNAM- , del Instituto Politécnico Nacional, el CONAFE , el INEA , el CAPFCE , el Libro de Texto Gratuito, las Telesecundarias, las Universidades Estatales, los Institutos Tecnológicos y decenas más; periodo en el cual igualmente se logró la universalización de la educación primaria, la expansión de la matrícula en preescolar y secundaria, etc., que han hecho que a pesar de los juicios lapidarios de propios y extraños, el sistema educativo mexicano sea uno de los más grandes, diversos y complejos del planeta, con niveles de calidad en términos de aprendizajes muy cercanos a los esperables para un país con 44 millones de sus habitantes en situación de pobreza o pobreza extrema, afirmación que se puede sustentar a partir del análisis de los resultados numéricos de las pruebas de matemáticas de PISA 2022 y una regresión simple de dichos resultados controlados por el Índice de Desarrollo Humano IDH de Naciones Unidas .

Como muestra de lo anterior, en la siguiente sección de este ensayo argumentativo, se exponen algunas gráficas, tablas e interpretaciones que permiten dar sustento a la afirmación de que la educación mexicana vista a la luz de los resultados comparativos del Programa para la Evaluación Internacional de Alumnos PISA, tiene un nivel muy cercano al esperable en función de la mezcla socioeconómica del país, o sea, sus resultados comparados no son ni mayores ni menores a lo esperable según sus condiciones.

Volviendo a la metáfora del “niño no deseado”, conviene mencionar que finalmente a 6 años de su nacimiento y a pesar de que se hicieron cosas interesantes y valiosas, que contó con equipos técnicos de muy buen nivel, se ve arrastrado a un nuevo escenario político, donde la mayor parte de los organismos autónomos pierde esa calidad y finalmente “el niño” ni caminó, ni habló, ni fue parte del régimen, ni fue oposición, de tal suerte que sin pena ni gloria en el mes de diciembre pasado con la mayoría calificada del senado, de la Cámara de Diputados y de más de tres cuartas partes de las legislaturas de los estados el niño deja de existir, tal cual lo hizo su antecesor, solo que en esta ocasión, se extingue por completo, ni formará parte de ningún Programa Sectorial de Educación.

La evaluación educativa, resultados y comportamientos contextualizados.

Como complemento a este relato del paralelismo de los Programas Sectoriales de Educación y la Evaluación educativa, y con el objeto de alcanzar una visión más comprensiva del fenómeno, se presentan más adelante algunos datos sobre los niveles de aprendizaje de la población mexicana, para lo cual echaremos mano del instrumento de mayor cobertura a nivel mundial -81 países en la actualidad-, donde México participa como país fundador desde el año 2000 y que a lo largo de los años ha sido el modelo más consistente, cíclico -cada 3 años- y que observa las disciplinas básicas del aprendizaje -Lenguaje, Matemáticas y Ciencias- para la población escolar de 15 años de edad, el “Programa para la Evaluación Internacional de Alumnos PISA”, del cual para efectos de este ensayo presentaremos un breve análisis a partir de los resultados simples de su última aplicación en 2022 (postpandemia), solo del área de matemáticas para no sobrecargar el documento y con algunas referencias a los resultados de 2000 primera aplicación y de 2018, aplicación prepandemia.

Así mismo, para contextualizar dichos resultados se presentarán algunas regresiones lineales simples que permitan identificar la relación que existe entre los resultados de PISA y las condiciones del contexto de los países, lo cual permite saber: 1. Aproximadamente qué porcentaje de los resultados de PISA depende de las condiciones de contextos de los países y no necesariamente de la intensión y esfuerzo coyuntural de los actores del hecho educativo al ser evaluados, 2. Cuál es el puntaje esperable en PISA a partir de las condiciones de contexto de cada país, y 3. Cuál es la diferencia entre el puntaje esperable según las condiciones de contexto de cada país y los resultados realmente obtenidos en la prueba PISA, como superávit o déficit de los sistemas educativos de los países; acompañado de interpretaciones puntuales al respecto (Palafox, 2023).

Así entonces, inicialmente se presenta la Figura 1, Ordenamiento inicial de los países según los resultados de PISA 2022 en Matemáticas (última evaluación publicada por la OCDE), donde con colores se destacan los países que pertenecen a la OCDE o no, el promedio de los países de la OCDE, y los países que son o no latinoamericanos; así mismo, se indican puntualmente algunos puntajes: del promedio OCDE, los primeros 5 países que encabezan la distribución, los últimos 5 países, los países latinoamericanos y otros países de interés, tales como: EEUU por nuestra vecindad e importancia y Vietnam por ser el país que como tal, observa la mayor distancia positiva (+99), entre el puntaje esperado según su IDH (370) y el realmente obtenido en PISA2022 (469). Todo lo anterior, acompañado de una serie de comentarios explicativos o interpretaciones iniciales, que describen algunos comportamientos de interés a partir del gráfico.

Figura 1. Ordenamiento inicial de los países según los resultados de PISA 2022 en Matemáticas.

Recuperado de:

https://www.oecd-ilibrary.org/docserver/5f07c754-en.pdf?expires=1633045154&id=id&accname=guest&checksum=B6BB9ACA0D16FAD1A3D26865D608924E .

Interpretaciones iniciales de los resultados de matemáticas en PISA 2022

1. Se incrementan los países y economías participantes de 41 en 2000 a 75 en 2018 y a 81 en 2022, equivalentes estos últimos a un 97% de aumento con respecto a 2000 y un 8% con respecto a 2018.

2. Así, en definitiva, los participantes en 2022 en términos de países representan un 40% del total aproximado de 220 considerados para el total del mundo, cifra que se reduce si se considera que en la muestra de participantes algunos son economías y no países.

3. En 2022 se reduce marginalmente el sesgo de países mayoritariamente con Índices de Desarrollo Humano Alto o Muy Alto al incorporarse algunos países de desarrollo medio, pero ninguno de desarrollo bajo.

4. En síntesis, la representatividad del estudio es menor al 50 % de países del planeta y casi en su totalidad de desarrollo alto y muy alto.

5. Por lo que corresponde a Latinoamérica, la representación nuevamente se incrementa al pasar de los 10 de 2018 a 12 del total de 19 existentes, o sea, en términos de países participa el 63% de la región.

6. En cuanto a resultados promedio propiamente dichos, el comportamiento general es muy similar a 2018, repitiéndose en 2022 que si bien los países que pertenecen a la OCDE siguen siendo los que observan puntajes altos, esto no es así en el extremo superior de la escala, ya que cuatro de los 5 puntajes más altos (Singapur, Macao (China), Chinese Taipéi, Hong Kong (China), no pertenecen a la Organización (solo Japón pertenece), indicativo de que pertenecer a la OCDE no es condición sine cuan non para obtener los resultados más altos en este tipo de ordenamientos.

7. Complementariamente, también es de hacer notar que de las cinco entidades que obtienen los puntajes más altos, las cinco pertenecen al oriente, aun cuando tres de ellas no representan a países completos, sino una economía o ciudad.

8. Por lo que toca a los países latinoamericanos, si bien no son los que tienen los puntajes menores como en 2000, pertenezcan o no a la OCDE, obtienen puntajes por debajo del promedio de la OCDE, por debajo de la mitad de la distribución, y los 12 están ubicados dentro de los 30 de menores puntajes de toda la distribución, confirmando la predicción hecha por el autor de este ensayo en 1998 (Palafox, 2023), lo cual da cuenta de lo predecible en términos generales de los resultados de este tipo de estudios, de lo que se hará un análisis más detallado e iluminador más adelante al referirnos al IDH.

Visto lo anterior y como complemento a ello, a continuación, se presenta la Figura 2. Dispersión de países en función del puntaje de PISA 2022 en matemáticas y el IDH de 2022, correspondiente a la regresión simple de los resultados de PISA 2022 relacionados con el IDH del mismo año, y la Tabla 1. Ordenamiento de países por el puntaje diferencial entre lo esperado según su IDH 2022 y lo realmente obtenido en PISA 2022 (Índice de Esfuerzo Escolar IEE o residuos), así como las observaciones que derivan de ambos elementos.

Figura 2. Dispersión de países en función del puntaje de PISA 2022 en matemáticas y el IDH de 2022.

Fuente: Elaboración propia con información del PNUD y la OCDE 2022,

Tabla 1. Ordenamiento de países por el puntaje diferencial entre lo esperado según su IDH 2022 y lo realmente obtenido en PISA 2022 (Índice de Esfuerzo Escolar IEE o residuos ).

Fuente: Elaboración propia con información del PNUD y la OCDE 2022.

* Países con anotaciones especificas en el reporte original de la OCDE que se recomienda consultar..

De la Figura 2 y su consecuente Tabla 1, entre otras cosas se observa que:

1. Este gráfico y su tabla incluyen todos los países y economías que participaron en PISA 2022 para los cuales existe el IDH para el mismo año y que además participaron en 2000.

2. El R² del ejercicio para 2022 es de 0.6254, estadísticamente similar a lo que ocurrió para 2000, lo cual nuevamente da cuenta de una correlación lineal importante entre ambas variables, por lo que se puede afirmar que el IDH es un buen predictor del puntaje de PISA.

3. Siguiendo el mismo criterio de análisis que se puede hacer para 2000 y 2018, considerando la diferencia entre el puntaje esperado (línea de regresión) y el puntaje realmente logrado, valor estadísticamente definido como “Residuo” y en este caso denominado Índice de Esfuerzo Escolar (IEE), las posiciones cambian para 2022 con relación al ordenamiento original de la OCDE, al igual que se verá en los dos años antecedente (2000 y 2028).

4. Así entonces, en el extremo superior del nuevo ordenamiento por IEE se observa que ahora en primer sitio aparece Japón que sube un lugar, así mismo, mejoran Corea y Hong Kong que cambian de posición, pero se mantienen dentro de los 5 primeros. Por otra parte, salen de este grupo Canadá y Suecia que pasan del 5 al 9 y del 4 al 11 respectivamente, dando espacio Latvia del 15 al 4 y Polonia del 7 al 5.

5. En el otro extremo del ordenamiento, donde los puntajes son originalmente los más bajos, Argentina es el único país que se mantiene en este grupo, Indonesia, Perú, Brasil y Tailandia salen del grupo mejorando su posición en 14, 8, 5 y 1 lugar respectivamente, en tanto que ocupan los lugares que ellos dejan Noruega (del 24 al 32), Grecia (del 28 al 33), Chile (del 30 al 34) e Islandia (del 26 al 35).

6. Con independencia de los comportamientos de los primeros y últimos cinco lugares vistos en los puntos anteriores, es prudente llamar la atención sobre los casos más extremos, aquellos que tienen las mayores diferencias entre el lugar logrado originalmente y el nuevo que ocupan por IEE. En primer término, Hungría y Portugal son los dos países que remontan más posiciones, ambos con 14; en tanto que negativamente Irlanda es el país que más posiciones pierde, con menos 11.

7. En el caso de México, al considerar el IEE, destaca que pasa del lugar 31º original del ordenamiento de PISA 2022, al 20º, o sea que avanza 11 lugares y queda a tan sólo -3.495 puntos de la escala de PISA por debajo del esperable según su IDH, diferencia muy similar a la lograda en 2018 pero en un contexto impuesto por la pandemia de baja generalizada del puntaje PISA, lo que indudablemente es un indicio de que si bien aún no se logra el nivel esperable, el comportamiento no es desastroso, como algunos pseudo expertos en educación afirman, y que de acuerdo al IDH 2022 México queda por encima de Finlandia, Indonesia, Australia, Nueva Zelanda, Perú, Suecia, Estados Unidos, Alemania, Brasil, Israel, Tailandia, Noruega, Grecia, Chile, Islandia y Argentina, de los cuales la mayoría son países miembros activos actualmente de la OCDE (solo Indonesia, Perú, Brasil, Tailandia y Argentina, no lo son), visión que rompe con las afirmaciones descontextualizadas que de manera tendenciosa o “amarillista” llaman a la descalificación del sistema educativo mexicano per sé equivocadamente.

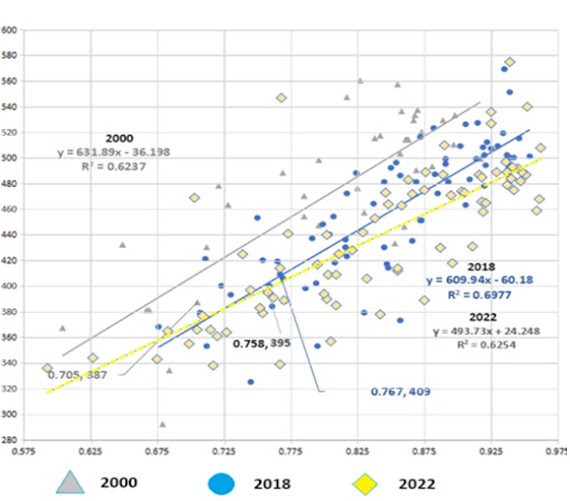

Complementariamente, se presentan tres elementos comparativos de PISA 2000, 2018 y 2022. La Figura 3. Dispersión de países en función del puntaje de PISA en matemáticas y el IDH de los años 2000, 2018 y 2022 y sus correspondientes comentarios al respecto, –presuponiendo que los instrumentos aplicados son equivalentes en cuanto al grado de dificultad–.

Figura 3. Dispersión de países en función del puntaje de PISA en matemáticas y el IDH de los años 2000, 2018 y 2022.

Fuente: Elaboración propia con información del PNUD y la OCDE 2000, 2018 y 2022.

De la Figura 3 comparativa, se puede comentar que:

1. En el gráfico se incluyen los países o economías que participan en PISA 2000, 2018 y 2022, que además tienen IDH para los 3 años.

a. Las líneas de regresión reflejan el incremento generalizado del IDH, donde en 2018 parte de un valor superior al de 2000.

b. Así mismo, dichas líneas son de diferente longitud debido a la reducción en la dispersión de los valores del IDH entre 2000 y 2018.

c. Aun cuando ambas variables tienen un comportamiento al alza, es más notorio el caso del IDH, sobre todo en el caso de los países con menor IDH..

d. México entre estos dos años incrementa tanto su IDH, como en su puntaje promedio de PISA y se acerca más al esperable según su IDH.

3. Lo anterior es distinto al comparar las dos primeras aplicaciones (2000 y 2018), con 2022, en que:

a. Según las líneas de regresiones, para el año 2022 se cae tanto el IDH, como los puntajes de PISA, con mayor incidencia en los países en que son más altos los puntajes de PISA, lo cual hipotéticamente pudiera ser consecuencia del COVID 19, que como ya se apuntó en párrafos anteriores, convendría profundizar más al respecto.

b. En el caso de México al comparar 2018 con 2022, a pesar del efecto del COVID 19 antes citado, reflejado en la caída de su IDH de 0.767 en 2018 a 0.758 en 2022 y por ende en PISA (de 409 a 395), contrario a lo que se pudiera suponer, mantiene en -3 la distancia que le separa entre lo esperable según su IDH y lo realmente logrado.

Por último, en este análisis de resultados PISA controlados por el IDH, se presentan la Tabla 2. Puntajes comparados de matemáticas PISA 2000, 2018 y 2022 y sus diferencias aritméticas interanuales. Países que participaron en los tres ejercicios, y la Figura 4. Diferencias de puntajes de los resultados de PISA 2000, 2018 y 2022 en Matemáticas, igualmente solo para los países que participaron en los tres ejercicios, mostrando las diferencias de puntajes en las tres aplicaciones, con sus correspondientes comentarios específicos

Tabla 2. Puntajes comparados de matemáticas PISA 2000, 2018 y 2022 y sus diferencias aritméticas interanuales. Países que participaron en los tres ejercicios.

Fuente: elaboración propia con información de OCDE, 2000, 2018 y 2022 mencionados anteriormente.

Figura 4. Diferencias de puntajes de los resultados de PISA 2000, 2018 y 2022 en Matemáticas.

Fuente: elaboración propia con información de OCDE, 2000, 2018 y 2022 mencionados anteriormente.

Una lectura inicial de los resultados comparados de los tres ejercicios mostrados en la Tabla 2 y la Figura 4, nos indicaría lo siguiente:

1. 36 de los 41 países originales de 2000 también participaron en 2018 y en 2022, de los cueles 21 pertenecen a la OCDE.

2. Ningún país repite el mismo puntaje y las diferencias son tanto de incremento como de decremento, donde el decremento en las tres comparaciones, da indicios de algunos comportamientos que llaman la atención.

a. Entre 2000 y 2018 si bien hay incrementos y decrementos, estos tienden más a compensarse, en resumen 17 países incrementan y 20 decrecen, pero en la suma de las diferencias de los puntajes promedio de los países de la comparación, el saldo es favorable a crecer con +121 puntos.

b. En las otras comparaciones la situación es notoriamente diferente, en las dos (2022 menos 2000 y 2022 menos 2018) la tendencia es más acentuada al decrecimiento, 8 países crecen y 27 decrecen entre 2022 y 2000, en tanto que entre 2022 y 2018 solo 2 crecen y los otros 34 países decrecen; lo anterior en términos de la suma de los promedios de los países de la comparación son números negativos en los dos casos (decrementos), entre 2000 y 2022 o sea en un periodo de veintidós años se cae en -454 el puntaje del promedio sumados de los países de la comparación, en tanto que entre 2018 - 2022, en tan solo 4 años, la caída es de -575 puntos.

c. Una interpretación plausible de esta importante caída del promedio en la comparación de 2022 - 2018 es el efecto global del COVID 19, lo cual merece un análisis más profundo que esta mera referencia del hecho y ya ha sido objeto de múltiples cavilaciones y hasta tesis doctorales, donde por ejemplo, se compara este comportamiento contra las tasas de mortalidad por COVID-19 a los efectos de comprobar o negar esta hipótesis o interpretación causal.

3. En cuanto al caso concreto de México y los países latinoamericanos:

a. Entre 2018 - 2000 nuestro país crece +22, junto con la mayoría de los países latinoamericanos que obtienen saldos a favor, en tanto que solo en el caso de Argentina su promedio decrece (-9).

b. Destaca en términos de crecimiento Perú, que obtiene el mayor crecimiento de todos los países de la comparación, sean latinoamericanos o no, con +108 puntos.

c. En este mismo sentido, es de destacar que junto con Perú, Brasil y Chile son los países que encabezan los países que crecen a nivel global.

d. Para la comparación 2022 - 2000 los puntajes promedio decrecen entre los dos años de la comparación.

e. Por último, al comparase 2022 - 2018, todos los países latinoamericanos decrecen, por lo que igualmente es válido atribuir este decrecimiento generalizado al COVID-19.

Complementariamente, conviene mencionar que con independencia del crecimiento o decrecimiento de los puntajes promedio de PISA en los años comprados, los indicadores estadísticos de la correlación entre estos años, es de:

1. Entre 2000 y 2018, el coeficiente de determinación o R2 es de 0.833

2. Entre 2018-2022, el coeficiente de determinación o R2 es de 0.924

3. Entre 2000 y 2022, el coeficiente de determinación o R2 es de 0.817

Coeficientes todos que dan cuenta de que los puntajes de PISA en el tiempo son una variable robusta y consistente internamente.

Recomendaciones

Así entonces, basados en la evidencia empírica expuesta a lo largo de todo este ensayo argumentativo, es claro que en materia educativa, al menos durante la vida de los llamados Programas Sectoriales de Educación, su importancia relativa, postulados y ejecución generalmente se han visto fuertemente impactados por contextos de orden político coyuntural, y por tanto, es en esa arena donde en la práctica se toman las grandes decisiones de política educativa, donde hay que poner las preocupaciones, la visión y donde se debe de lograr que la evaluación recupere lo perdido con tanto “ir y venir”, con tantos “tres pasos adelante y dos atrás”, tanto sobre dimensionamiento, ello, para volver al modelo austero, riguroso y nada pretencioso que distinguieron a las prácticas planificadoras de los 70’s y 80’s del Siglo pasado, donde lo importante era “la camiseta”, la meta, el sentido común y el compromiso con los niños; igualmente es recomendable volver al trabajo discreto, serio y riguroso de los fundadores del INEE, de tal suerte que la evaluación renuncie a pretender ser la solución de todos los problemas, que no vuelva a vincularse con procesos administrativos ajenos a su naturaleza y que vuelva a la rigurosidad del dato, la información y el conocimiento de la realidad educativa, en cuyo caso me atrevería a rescatar algunas recomendaciones que en otro momento propuse como resultado de mi experiencia empírica sobre el tema y del análisis contextualizado de los resultados de México en las evaluaciones estandarizadas de ámbito regional o internacional.

Así las cosas, lo primero es que hay que poner al centro de la reflexión es el último hecho político que determinará mucho de lo que la nueva administración considerará en el Programa Sectorial de Educación 2025-2030, relacionado con lo sucedido en la Cámara de Diputados el día 22 de noviembre de 2024, en que se aprueba por esa instancia una nueva Reforma Constitucional que deroga la Fracción IX del Artículo Tercero, lo que desembocará en la extinción de Mejoredu, lo cual no pasa por las prioridades naturales del sector, sino que más bien se inserta en las dimensiones de la gobernanza y la gobernabilidad.

Por tal razón, se hace necesario buscar la forma de “vacunar” al sector educativo y a la evaluación educativa contra las influencias políticas y su veleidosidad, lo cual quizá pudiera hacerse:

a. mediante la etiquetación fiscal de algunos impuestos (IETU, IDE u otros ya existentes o de nueva creación), para el financiamiento fijo de algunas funciones;

b. en el mismo orden de ideas, se puede explorar la creación de impuestos específicos para financiar igualmente algunas funciones educativas;

c. destinar los productos derivados de algunos hechos como la extinción de dominio o los intestados, también al financiamiento fijo de algunas actividades educativas;

d. establecer fórmulas de distribución del gasto educativo nacional trasparentes y fijas, en función de políticas de equidad y protección de los grupos marginales, de tal suerte que exista un equilibrio distributivo que ayude igualar las oportunidades educativas de todos los grupos de población; etc., todo lo cual tiene una traducción directa en el contenido del Programa Sectorial de Educación 2025-2030.

En el tema de la evaluación educativa es urgente instalar mecanismos cíclicos y transparentes que vaya más allá del propio Programa Sectorial de Educación:

a. que pongan en el centro de las preocupaciones educativas nacionales el aprendizaje de los alumnos,

b. que busquen dentro de lo posible, que las acciones del sector se vinculen con el aprendizaje, sobre todo aquellas de nueva creación, a los efectos de poder determinar sus aportes o no al aprendizaje de la población escolar.

c. que por ningún motivo el país abandone el Programa Internacional para la Evaluación de Estudiantes, PISA, como una forma de monitorear los avances y retrocesos de nuestro sistema educativo nacional en materia de aprendizajes básicos,

d. buscar que además de los informes comparativos que comúnmente presenta la OCDE al respecto, se incluya con la misma visibilidad resultados controlados por el Índice de Desarrollo Humano (IDH) como se hizo en este ensayo con el Índice de Esfuerzo Escolar, como una forma de evitar las comparaciones simples que llevan a conclusiones espurias sobre el esfuerzo que cada país invierte en otorgar a su población un buen nivel educativo, considerando sus distintos puntos de partida y desarrollo,

e. considerando que PISA no mide o mide solo tangencialmente los aspectos más significativos de una educación de calidad, ampliar con mecanismos especifico la evaluación de otros aspectos, tales como:

i. los 4 pilares de la educación planteados a nivel internacional en el Informe a la UNESCO de la Comisión sobre la Educación para el Siglo XXI, “aprender a ser, aprender a conocer, aprender a hacer y aprender a vivir juntos” , a los cuales bien podría añadirse “aprender a emprender”;

ii. o, lo planteado en el ámbito nacional por Carlos Muñoz Izquierdo (qepd), que sugería como las dimensiones más importantes de la calidad educativa y sus criterios de evaluación a: 1. “la Dimensión Filosófica-Relevancia, 2. la Dimensión Pedagógica-Eficacia, 3. la Dimensión Social-Equidad, 4. la Dimensión Cultural-Pertinencia, y 5. la Dimensión Económica-Eficiencia” .

f. optar por referirse a los resultados de PISA como mayores o menores puntajes, pero nunca como mejores o peores puntajes, ya que hacerlo de esta última forma tiende a sobredimensionar a los países o entidades participantes cuyas poblaciones tienen mejores condiciones de inicio, en tanto que, por el contrario, se estigmatizan a aquellos cuyas condiciones de partida son en extremo más difíciles, complicadas o hasta en algunos casos, verdaderamente negativas para educar a sus pueblos,